Зачем прокси нужны при парсинге

Ограничения сайтов

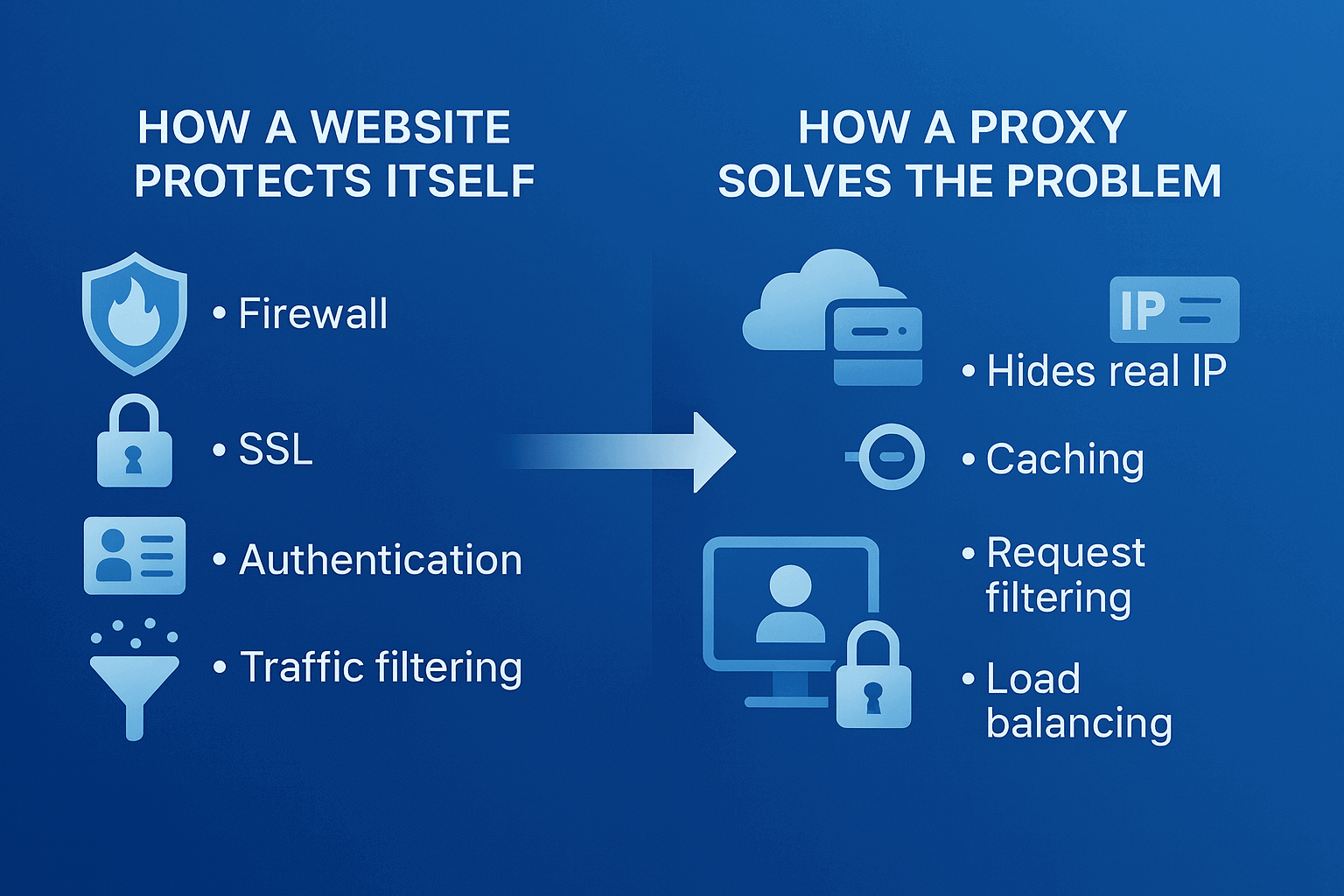

Попробуйте собрать данные с любого крупного сайта без прокси — через пару минут увидите капчу или сообщение о блокировке. Это реальность современного интернета. Владельцы ресурсов тратят миллионы на защиту от ботов. Cloudflare, DataDome, PerimeterX — эти системы отслеживают каждое действие посетителя. После десятка быстрых переходов по страницам появляется капча, еще через минуту следует полная блокировка IP. Антибот-системы становятся умнее с каждым днем, и прокси для парсинга остаются единственным способом собирать данные в промышленных масштабах.

Как сайты выявляют парсеров

Представьте, что обычный человек читает статью 30-60 секунд, кликает мышкой, иногда возвращается назад. Парсер же загружает 50 страниц за секунду, игнорирует картинки, никогда не двигает курсором. Разница очевидна даже простейшему алгоритму.

Технические маркеры еще проще отследить. Парсеры часто используют устаревшие User-Agent, не загружают JavaScript, отправляют запросы с одинаковыми интервалами. Некоторые сайты проверяют даже порядок загрузки ресурсов страницы — настоящий браузер сначала запросит CSS, потом изображения. Бот полезет сразу за данными. Парсинг прокси серверов маскирует эти признаки, но полностью имитировать человека все равно сложно.

Почему без прокси парсинг быстро блокируется

Математика простая. средний интернет-магазин получает 10-20 запросов в минуту от одного посетителя максимум. Парсер отправляет 1000. Система безопасности срабатывает мгновенно. Даже если снизить скорость, паттерн поведения выдаст бота через 10-15 минут.

Реальный пример это парсинг товаров на маркетплейсе. Без прокси удается собрать информацию о 50-100 позициях. Потом — бан на сутки или навсегда. С ротацией IP через прокси парсинг онлайн продолжается часами, собирая десятки тысяч карточек товаров.

Как это работает на практике:

- Сценарий без прокси: 1 IP → 1000 запросов → блокировка через 5 минут

- Сценарий с прокси: 100 IP → по 10 запросов с каждого → сайт видит обычных пользователей

Содержание

- Что представляет собой сервис анонимных прокси

- Как работает анонимный прокси

- Уровни анонимности прокси

- Виды анонимных прокси

- Основные преимущества использования анонимных прокси

- Риски и ограничения

- Как настроить и использовать анонимный прокси

- Как исправить ошибку "Обнаружен анонимный прокси"

- Как выбрать надёжный сервис анонимных прокси

- Часто задаваемые вопросы

- Заключение

- VPN и прокси: основные различия

- Что такое прокси-сервер?

- Что такое VPN?

- Безопасность и конфиденциальность

- Скорость и производительность

- Когда стоит использовать прокси-сервер?

- Когда стоит использовать VPN?

- Стоит ли использовать VPN и прокси одновременно?

- Ошибки при выборе между VPN и прокси

- Разрушаем мифы о VPN и прокси

- VPN или прокси: как выбрать подходящий вариант?

- FAQ

- Заключение

- Что такое прокси сервер для Google Chrome и зачем он нужен

- Как работает прокси в браузере Chrome

- Способы настройки прокси в Google Chrome

- Настройка прокси в Google Chrome через Windows

- Настройка прокси в Google Chrome через macOS

- Настройка прокси для Chrome через расширения

- Настройка прокси в Chrome на Android

- Настройка прокси в Chrome на iPhone и iPad

- Проверка подключения и тест скорости

- Типичные ошибки при работе с прокси в Chrome

- FAQ

- Заключение

- Зачем нужны прокси для Reddit

- Почему Reddit может быть заблокирован

- Какие ограничения есть у Reddit

- Кому и как помогут прокси

- Что можно делать с прокси для Reddit

- Как выбрать подходящий тип прокси для Reddit

- Proxy vs VPN для Reddit

- Как настроить и использовать прокси для Reddit

- Топ провайдеров прокси для Reddit в 2025 году

- Распространенные проблемы и решения

- Практические сценарии использования прокси

- FAQ

- Заключение

- Почему LinkedIn требует использования прокси

- Как прокси помогают в работе с инструментами LinkedIn

- Типы прокси для LinkedIn и критерии выбора

- 10 лучших прокси-провайдеров для LinkedIn

- Настройка и использование прокси

- Советы по безопасному масштабированию LinkedIn outreach

- FAQ

- Заключение: как построить стабильную систему работы с LinkedIn через прокси

- Как Amazon выявляет и блокирует прокси

- Преимущества использования прокси для Amazon

- Какие типы прокси лучше всего подходят для Amazon

- Лучшие провайдеры резидентских прокси для Amazon (2025)

- Ключевые характеристики хорошего прокси-провайдера для Amazon

- Как настроить прокси для Amazon

- Частые проблемы при работе с прокси на Amazon

- Как использовать прокси Amazon для разных задач

- Лучшие практики безопасного использования прокси для Amazon

- FAQ

- Заключение – выбирайте стабильность, а не количество

- Где вводить настройки прокси на Android

- Пошаговая настройка прокси на Android через Wi-Fi

- Почему прокси на Wi-Fi может не работать

- Настройка прокси на Android для мобильного интернета

- Использование приложений для настройки прокси на Android

- Как отключить прокси на Android

- Как проверить, работает ли прокси на Android

- FAQ

- Заключение

- Шаг 1 — Скачайте и установите VMLogin

- Шаг 2 — Создайте новый профиль браузера

- Шаг 3 — Получите данные доступа к Gonzo Proxy

- Шаг 4 — Настройте параметры прокси в VMLogin

- Шаг 5 — Проверьте подключение прокси

- Шаг 6 — Запустите профиль браузера

- Шаг 7 — Опционально: Настройка нескольких профилей / Ротация сессий

- Шаг 8 — Устранение распространенных проблем

- Шаг 9 — Начните автоматизацию с Gonzo Proxy + VMLogin

- Что такое анонимайзер простыми словами

- Чем отличается анонимайзер от прокси и VPN

- Как работает анонимайзер

- Типы анонимайзеров и уровни анонимности

- Как форматировать прокси для работы с анонимайзерами

- Как использовать анонимайзер для доступа к заблокированным сайтам

- Преимущества и риски использования анонимайзеров

- Как выбрать анонимайзер или прокси под задачи

- FAQ

- Conclusion

- Как быстро и эффективно продавать на Авито

- Что такое масспостинг на Авито и зачем он нужен

- Ручной и автоматизированный масспостинг

- Мультиаккаунтинг: как управлять несколькими аккаунтами на Авито

- Пошаговый план запуска

- Как не попасть в бан при масспостинге и мультиаккаунтинге

- Масспостинг vs альтернативные способы продаж

- FAQ

- Conclusion

- Для чего нужен антидетект на Android и iPhone

- Топ-решения для Android и iOS в 2025 году

- Как правильно настроить антидетект браузер на телефоне

- Ограничения и риски при работе с мобильными антидетектами

- Как прокси повышают эффективность antidetect браузеров

- Чек-лист по выбору антидетекта для телефона

- FAQ

- Заключение

- Что значит прозрачный (transparent) прокси

- Как работает прозрачный прокси в реальной сети

- Сферы применения "невидимого" прокси

- Преимущества и недостатки прозрачного прокси

- Настройка прозрачного прокси: пошагово

- Безопасны ли прозрачные прокси

- Популярные решения для настройки прозрачного прокси

- Чек-лист по работе с прозрачными (transparent) прокси

- FAQ

- Заключение

- Почему прокси обязательны для работы в Dolphin Anty

- Виды прокси, которые можно подключить к Dolphin

- Ротационные vs статические

- Пошаговая инструкция: как добавить прокси в Dolphin Anty

- Типичные ошибки при подключении прокси и как их исправить

- Как выбрать надежные прокси для Dolphin Anty

- Советы по оптимизации расходов

- Практические кейсы использования Dolphin Anty с прокси

- FAQ

- Итоги

- Виды прокси, которые используют для парсинга

- Как выбрать прокси для парсинга

- Настройка и ротация прокси при парсинге

- Технические приемы для обхода блокировок

- Практика: как собрать пул прокси для парсинга

- Метрики и мониторинг качества парсинга

- Лучшие практики и готовые решения

- FAQ

- Итоги: какой прокси выбрать под парсинг

- Как работают прокси в онлайн-ставках

- Виды прокси, подходящих для беттинга

- Какие задачи решают прокси в беттинге

- ТОП прокси-сервисов для букмекерских контор в 2025 году

- Сравнительная таблица прокси-сервисов

- Как выбрать прокси для букмекерской конторы

- Как настроить прокси для ставок

- Рекомендации по безопасному использованию прокси для беттинга

- FAQ

- Итоги

- Как работают прокси в арбитраже трафика

- Виды прокси для арбитража и их особенности

- Какие задачи решают прокси в арбитраже

- ТОП прокси-сервисов для арбитража в 2025 году

- Сравнительная таблица прокси-сервисов

- Как выбрать качественный прокси для арбитража

- Как настроить прокси для арбитража

- Рекомендации по безопасному использованию прокси

- FAQ

- Итоги

- Для чего нужны резидентские прокси?

- Как работают резидентские прокси?

- Чем резидентские прокси отличаются от других?

- Подключаем резидентские прокси от GonzoProxy

- Примеры использования резидентских прокси от GonzoProxy в Python

- Плюсы и минусы резидентских прокси

- Как проверить резидентские прокси?

- Ошибки при использовании

- FAQ

- Заключение

- Почему Facebook часто блокирует аккаунты и карты?

- Зачем использовать виртуальную карту для Facebook Ads?

- Multicards.io — надёжный сервис виртуальных карт для рекламы в Meta

- Покупать или создавать аккаунты Facebook Ads?

- Зачем нужны прокси?

- Какие прокси лучше всего подходят для рекламы?

- GonzoProxy — качественные прокси для Facebook Ads

- Как безопасно привязать виртуальную карту к Facebook Ads

- Итоговые рекомендации

- Что такое DePIN-ферма и зачем она вам нужна?

- Что вообще такое DePIN?

- Вот ещё примеры DePIN-проектов, которые уже в топе

- Что понадобится для запуска своей DePIN-фермы?

- Как создать профили и настроить антидетект-браузер?

- Как выбрать и настроить прокси?

- Что с Twitter/X аккаунтами?

- Как создать почты?

- Перед запуском — важный совет!

- Как грамотно замиксовать аккаунты?

- Как современные антифрод-системы отслеживают нарушителей

- Google Ads: особенности антифрода в 2025

- Как понять что у тебя проблемы с прокси?

- Почему большинство прокси не работают с рекламными платформами

- Как выбрать и проверить прокси для рекламных платформ

- Стратегия стабильной работы с рекламными платформами

- Заключение: не экономь на инфраструктуре

Дата-центровые: когда подходят и какие риски

Серверные прокси стоят копейки — доллар за штуку или меньше при оптовой покупке. Работают быстро, пинг редко превышает 100 миллисекунд. Но есть нюанс, их IP-адреса принадлежат хостингам вроде Amazon AWS или DigitalOcean. Любая приличная система защиты знает эти диапазоны наизусть.

Где работают такие прокси? Новостные сайты, блоги без защиты, государственные порталы с открытыми данными. Где бесполезны? Социальные сети, маркетплейсы, билетные системы. Личный опыт показывает, что для серьезного парсинга дата-центровые прокси подходят только как вспомогательный инструмент для тестирования скриптов.

Резидентские: баланс скорости и анонимности

Это IP-адреса обычных домашних пользователей. Провайдер выдал адрес человеку, тот установил специальное ПО и делится подключением за деньги. Сайт видит запрос от "бабушки из Рязани" или "студента из Берлина" — никаких подозрений.

Скорость страдает — вместо 50 миллисекунд получаем 200-500. Зато можно спокойно парсить поисковики, собирать цены с Ozon или Wildberries, мониторить объявления на Avito. Стоимость зависит от качества. Хорошие сети берут 4-6 долларов за гигабайт, подешевле найти можно, но там половина адресов уже в черных списках.

Мобильные: обход антиботов и Cloudflare

Операторы сотовой связи используют технологию NAT, когда тысячи абонентов выходят в интернет через один внешний IP. Заблокировать такой адрес значит отрезать от сайта целый район или город. Поэтому мобильные прокси почти неуязвимы.

Цена кусается и составляет 30-50 долларов в месяц за один канал. Скорость плавает в зависимости от загрузки сети оператора. Зато можно забыть про Cloudflare и прочие защиты, потому что мобильный трафик они пропускают почти всегда. Идеальный вариант для парсинга Instagram, TikTok, банковских сайтов.

Бесплатные и публичные прокси: почему не работают для стабильного парсинга

Бесплатный сыр знаете где бывает. Публичные прокси — это адреса взломанных роутеров, зараженных компьютеров или honeypot-ловушки для сбора данных. Скорость ужасная, работает один из десяти, те что работают — уже везде забанены.

Пробовал ради эксперимента собрать 1000 бесплатных прокси. Рабочих оказалось 73. Из них только 8 смогли зайти на Amazon. Через час не работал ни один. Время потраченное на возню с ними стоит дороже нормального платного сервиса.

Количество IP-адресов и география

Начинающие часто спрашивают, хватит ли 10 прокси для парсинга. Смотря что парсить. Для сбора новостей с пары сайтов да, для мониторинга цен на маркетплейсе нужно минимум сотня, а лучше 500.

География критична при работе с локальными сервисами. Яндекс.Маркет показывает разные цены для Москвы и Владивостока. Amazon вообще не пустит с российского IP. Берите прокси из той страны, где находится целевая аудитория сайта. Исключение составляют международные ресурсы типа Wikipedia, там география не важна.

Поддержка протоколов (HTTP(S), SOCKS5)

HTTP-прокси хватает для 90% задач веб-скрейпинга. Все библиотеки парсинга их поддерживают из коробки. SOCKS5 нужен для специфических задач, таких как работа с мессенджерами, торрентами, игровыми серверами. Еще SOCKS5 лучше скрывает тип трафика, но для обычного парсинга это избыточно.

IPv6 пока экзотика. Большинство сайтов его не поддерживают или работают криво. IPv4 остается стандартом, хотя адресов становится все меньше и цены растут.

Наличие API и гибкой ротации

Без API придется каждый раз лезть в личный кабинет за новым списком прокси. При серьезных объемах это убивает автоматизацию. Нормальный сервис дает эндпоинт типа api.service.com/get_proxy, откуда скрипт сам забирает свежие адреса.

Ротация должна настраиваться под задачу. Для быстрого сбора ссылок — смена IP каждые 10 запросов. Для парсинга с авторизацией — держать сессию 30-60 минут. Сервисы без гибких настроек ротации лучше обходить стороной.

Метрики качества: аптайм, скорость отклика, процент «живых» IP

Чек-лист при выборе поставщика:

- Аптайм серверов минимум 99% (проверяется мониторингом неделю)

- Пинг до прокси не больше 300 мс для резидентских

- В пуле работает хотя бы 85% заявленных IP

- Мертвые прокси заменяются автоматически за 10-30 секунд

- Есть конкурентные подключения (минимум 100 потоков)

- Служба поддержки отвечает в течение часа

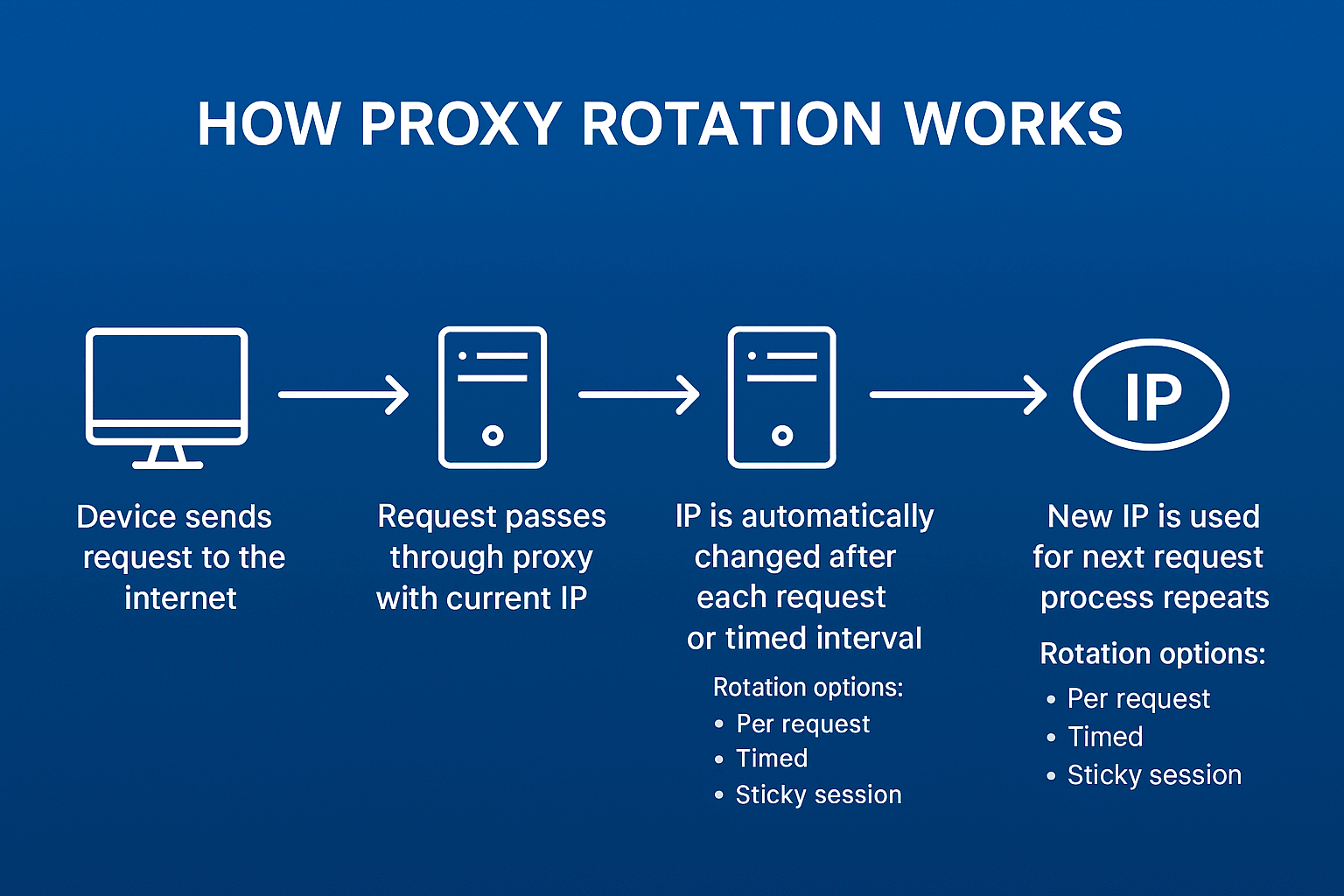

Зачем нужна ротация IP

Даже самый терпеливый сайт заподозрит неладное, если один IP сутками шерстит каталог товаров. Ротация создает иллюзию множества независимых пользователей. Вместо одного подозрительного бота сайт видит сотню обычных посетителей.

Проверено на практике. Без ротации парсер живет 10-30 минут, с правильной сменой IP работает сутками. Главное не переборщить, потому что слишком частая смена адресов тоже выглядит странно.

Ротация по времени vs ротация по запросам

Временная ротация проще в настройке. Задали интервал 5 минут, и парсер сам меняет IP по таймеру. Подходит для неспешного сбора данных, когда важна стабильность сессии. Например, при парсинге форумов или соцсетей с авторизацией.

Ротация по запросам дает больше контроля. Новый IP каждые 20 обращений оптимально для агрессивного парсинга каталогов. Можно даже рандомизировать от 15 до 25 запросов, чтобы не было четкого паттерна.

TTL и сессии — как правильно работать с «долгими» прокси

Липкие сессии (sticky sessions) удерживают один IP для всей цепочки действий. Зашли на сайт, авторизовались, полистали каталог — все с одного адреса. Для сайта это выглядит естественно.

TTL задает максимальное время жизни подключения. Поставили 3600 секунд — через час прокси принудительно сменится. Это защита от ситуации, когда парсер завис на одном IP и начал долбить сайт однообразными запросами.

Балансировка нагрузки и распределение по потокам

Многопоточность ускоряет парсинг в разы, но тут важен баланс. 100 потоков через 10 прокси означает 10 запросов одновременно с каждого IP. Многовато для одного "пользователя". Лучше взять 100 прокси и распределить по одному на поток.

Личный опыт показывает оптимальную схему, когда количество потоков равно количеству прокси, деленному на 2. То есть для 50 прокси запускаем 25 потоков. Каждый поток работает с двумя IP попеременно. Нагрузка распределена, сайт не перегружен, данные собираются быстро.

Например, в GonzoProxy можно гибко настроить ротацию и менять IP раз в N секунд или после каждого запроса. Эффективно показывает себя в задачах по сбору выдачи поисковых систем, парсинга маркетплейсов, мониторинга цен конкурентов.

Как бороться с капчей

Капчи — головная боль любого парсера. Варианты решения расположу по возрастанию сложности и стоимости:

Самый простой способ заключается в снижении скорости и добавлении случайных задержек между запросами. Помогает в 30% случаев. Бесплатно, но медленно.

Антикапча-сервисы решают проблему за деньги. ReCaptcha стоит 2-3 доллара за тысячу разгадок, обычные картинки в 10 раз дешевле. Интегрируется за час, работает стабильно.

Продвинутый уровень — обучить нейросеть на своих данных. Требует датасет из 10000+ размеченных капч и пару недель возни с TensorFlow. Зато потом работает бесплатно и быстро.

JavaScript-челленджи и динамический контент

Cloudflare Under Attack Mode — кошмар парсера. Пять секунд крутится колесико, выполняется куча JavaScript-проверок, только потом пускают на сайт. Requests и BeautifulSoup тут бессильны.

Выход — браузерная автоматизация.

Selenium управляет настоящим Chrome, который честно выполняет все скрипты. Медленно, требовательно к ресурсам, зато работает почти везде. На сервере с 4 ядрами можно держать 10-15 браузеров параллельно.

from seleniumwire import webdriver # selenium-wire for proxy work

options = webdriver.ChromeOptions()

options.add_argument('--headless') # no GUI, save resources

proxy_options = {

'proxy': {

'http': 'http://user:pass@proxy_ip:port',

'https': 'https://user:pass@proxy_ip:port'

}

}

driver = webdriver.Chrome(seleniumwire_options=proxy_options, options=options)

driver.get('https://protected-site.com')

# Wait for JavaScript to load

driver.implicitly_wait(10)

Cookie wall и fingerprint-защита

Современные сайты собирают цифровой отпечаток браузера, включая разрешение экрана, список шрифтов, версию видеокарты, часовой пояс. Если отпечаток не меняется при смене IP, парсера вычислят.

Решение — антидетект-браузеры или библиотеки типа puppeteer-extra-plugin-stealth. Они рандомизируют параметры браузера, делая каждую сессию уникальной. Накладные расходы серьезные, но для ценных данных оправданы.

Логика повторных попыток при парсинге

Сеть — штука нестабильная. Прокси отвалился, сайт не ответил, таймаут соединения. Без retry-логики потеряете половину данных.

Мой проверенный алгоритм:

- Первая попытка с основным прокси

- Ошибка? Ждем 2-5 секунд (случайно), меняем IP

- Снова ошибка? Меняем User-Agent, чистим cookies

- Третья неудача? Помечаем URL как проблемный, откладываем на потом

- После 5 попыток — логируем и пропускаем

Обязательно различайте типы ошибок. 429 (Too Many Requests) — снизить скорость. 403 (Forbidden) — сменить прокси. 500 (Server Error) — подождать, сайт перегружен.

Где брать прокси

Варианты от худшего к лучшему:

Прокси-листы в интернете — мусор в 99% случаев. Даже не тратьте время.

Телеграм-каналы с "дешевыми прокси" — лотерея. Может повезет, может деньги потеряете.

Маркетплейсы типа proxy-seller — средний вариант. Цены завышены, но хоть какие-то гарантии есть.

Прямые поставщики — оптимально по соотношению цена/качество. Bright Data, Smartproxy, Oxylabs для западных проектов.

Свой пул через размещение ПО на устройствах пользователей обойдется дешево в долгосрочной перспективе, но нужны начальные инвестиции и время на раскрутку.

Как проверить «живость» прокси

Базовая проверка занимает секунды:

import requests

def check_proxy(proxy_url):

try:

response = requests.get('http://ipinfo.io/json',

proxies={'http': proxy_url, 'https': proxy_url},

timeout=5)

if response.status_code == 200:

return response.json()['ip'] # returns proxy's external IP

except:

return NoneНо это только начало. Надо проверить работу с целевым сайтом, измерить скорость, убедиться что IP не в черном списке. Полноценная проверка одного прокси занимает 30-60 секунд.

Автоматизация проверки и логирование

Ручная проверка сотен прокси — путь в никуда. Нужна автоматизация:

- Скрипт-валидатор проверяет новые прокси при добавлении

- Мониторинг каждые 10 минут тестирует случайную выборку

- После каждого использования делается отметка об успехе или проблеме

- Раз в час проводится полная проверка проблемных адресов

- Раз в сутки формируется отчет о состоянии пула

Вместо ручной проверки можно использовать готовые решения. Например, в проектах для e-commerce часто применяют сервисы уровня GonzoProxy — они позволяют быстро собрать пул IP с гео-разнообразием и встроенной ротацией. Это сокращает время на настройку и повышает стабильность парсинга.

Среднее время отклика прокси

Нормальные показатели сильно зависят от типа прокси и расстояния до сервера. Мой личный benchmark после сотен проектов:

Дата-центр в той же стране: 30-80мс — отлично, 80-150мс — нормально, больше 150мс — искать другого поставщика.

Резидентские прокси: 150-300мс — хороший показатель, 300-500мс — рабочий вариант, больше 500мс — только если других вариантов нет.

Мобильные всегда медленнее: 400-800мс считается нормой. Тут платим за качество, не за скорость.

Процент успешных запросов

Если success rate падает ниже 85%, значит что-то пошло не так. Возможные причины:

- Сайт усилил защиту (нужно адаптировать парсер)

- Прокси забанены (менять поставщика или пул)

- Слишком агрессивные настройки (снизить скорость)

- Технические проблемы на стороне цели (переждать)

Нормальный показатель для отлаженной системы — 92-97% успешных запросов. Идеальных 100% не бывает, интернет слишком нестабилен.

Количество банов по IP и блокировок

Допустимый процент зависит от агрессивности парсинга. При аккуратной работе максимум 2-3% адресов получают бан. При жестком парсинге защищенных сайтов до 10% это еще нормально.

Если банится больше 15% пула — пора менять стратегию. Либо прокси низкого качества, либо парсер слишком заметен.

Сколько «живет» прокси при постоянном использовании

Статистика из реальных проектов:

Бесплатные прокси: 30 минут - 2 часа. Потом либо сдыхают, либо банятся везде.

Дешевые дата-центровые ($0.5-1 за штуку): 12-48 часов активного использования.

Качественные резидентские: 5-10 дней при разумной нагрузке.

Мобильные прокси: 2-4 недели, некоторые работают месяцами.

Ключевое слово — "разумная нагрузка". Если долбить один сайт 24/7 с одного IP, даже мобильный прокси долго не протянет.

Когда выгоднее взять «прокси как сервис»

Простая математика показывает, что если тратите больше 10 часов в месяц на возню с прокси, пора брать готовый сервис. Время разработчика стоит дороже, чем разница в цене между сырыми прокси и управляемым решением.

Готовые сервисы дают API, автоматическую ротацию, замену мертвых IP, статистику, поддержку. Настройка занимает час вместо недели. Для стартапов и агентств это критично.

Open-source инструменты для управления пулом прокси

Проверенные временем решения:

ProxyBroker — Python-библиотека для поиска и проверки прокси. Умеет собирать бесплатные адреса с десятков источников. Для продакшена не годится, но для тестов сойдет.

Rotating Proxy — простая обертка для requests с автоматической сменой прокси при ошибках. Минималистично и эффективно.

HAProxy — промышленный балансировщик. Оверкилл для простого парсинга, но для серьезных проектов незаменим.

Squid — классический кеширующий прокси. Экономит трафик при повторных запросах к одинаковым URL.

ProxyChain — позволяет строить цепочки прокси для максимальной анонимности. Скорость падает в разы, но иногда это единственный способ.

Комбинация прокси с антидетект-браузерами

Связка прокси + антидетект-браузер дает почти 100% маскировку. Браузер меняет отпечаток устройства, прокси скрывает реальный IP. Вместе они делают парсер неотличимым от обычного пользователя.

Популярные антидетекты: Multilogin, GoLogin, AdsPower. Стоят от $30 в месяц, но для работы с дорогими данными окупаются мгновенно.

GonzoProxy, например, из коробки интегрируется с большинством антидетект-браузеров. Вставил данные прокси в профиль браузера — и работаешь. Особенно удобно при совмещении парсинга с управлением рекламными аккаунтами или социальными профилями.

FAQ

Коротко о главном для разных задач:

Тестирование и обучение — берите пачку дешевых дата-центровых прокси, потренируйтесь, поймите принципы.

Парсинг открытых данных (новости, блоги) — дата-центровые прокси с базовой ротацией, 50-100 штук хватит.

E-commerce и маркетплейсы — резидентские прокси обязательны, минимум 200-300 адресов, желательно из разных городов.

Социальные сети и мессенджеры — только мобильные прокси или премиум резидентские с низким фрод-скором.

SEO и анализ выдачи — резидентские прокси с точным геотаргетингом, отдельный пул для каждой страны.

Высоконагруженный скрейпинг — микс из дата-центровых для простых задач и резидентских для сложных участков.

Советы для разных объемов парсинга

Малый парсинг (до 10 000 запросов в день):

- Достаточно 20-30 резидентских прокси с ротацией каждые 30 минут

- Можно обойтись без сложной инфраструктуры — простой Python-скрипт с requests

- Дата-центровые прокси подойдут для незащищенных сайтов

Массовый парсинг (100 000+ запросов в день):

- Минимум 500 прокси в ротации, лучше 1000+

- Обязательна многопоточность и балансировка нагрузки

- Микс из 70% резидентских и 30% дата-центровых для оптимизации расходов

- Нужна система мониторинга и автозамены забаненных IP

Парсинг динамики цен:

- Критична стабильность — используйте только резидентские или мобильные прокси

- Важна география — прокси должны быть из региона целевой аудитории

- Настройте sticky sessions на 30-60 минут для имитации реального шоппинга

- Обязательно сохраняйте cookies между сессиями

Запомните главное: экономия на прокси оборачивается потерей времени и данных. Лучше заплатить на 20% больше за качественный сервис, чем постоянно бороться с блокировками и искать новые адреса. В долгосрочной перспективе качественные прокси для парсинга всегда окупаются.